AIoT市场为什么需要“CV+AI加速”的融合型处理器?

云端和边缘智能应用的大量爆发,让如今的AI正日益深入人心,成为海量电子类设备的标配。但各类AI应用在高潮迭起的同时,也产生了庞大体量的数据,这也让如今的处理器技术越来越不堪重负。以边缘侧智能设备为例,地平线张永谦日前在接受记者采访时曾表示,“截至目前,边缘侧的大量的数据中99%几乎都是未曾经过智能化处理或者结构化处理的垃圾数据,仅仅将其中部分数据送入云端进行智能处理,都会让厂商付出很大的代价。”

更不必谈,待5G应用全面落地之后,单位面积之内设备的接入数量以及整体的接入带宽都将比当前的4G应用高出一个数量级,这也必将给云端及边缘侧处理技术带来更大的压力,比如进一步加剧边缘侧数据和比较有限且难以实现的骨干网处理能力之间的矛盾。因此,如今有越来越多芯片公司开始发力AI边缘侧芯片,即便只是在国内,截至目前对外宣称正在从事AI芯片开发的企业都多达50-100家,这也为CEVA这样的IP提供商创造了越来越多跟进中国市场的机会。

CEVA营销副总裁Moshe Sheier

继去年的NeuPro产品在AIoT市场大卖之后,为进一步加强自身在AIoT芯片IP授权领域的优势,CEVA于不久前的比利时布鲁塞尔AutoSens展会上正式发布了用于边缘深度神经网络推理的第二代AI处理器架构NeuPro-S。CEVA营销副总裁Moshe Sheier也于近日来到深圳,为华强电子网等媒体分享了CEVA在AIoT芯片领域的思考与规划。

数据带宽瓶颈的破解之道

对于AI芯片来说,数据带宽已经成为一个非常明显的瓶颈。仅以视觉类前端设备的配置来看,业内预测2022年全球将有15亿个具有计算机视觉/AI功能的前端设备配置,其中,智能手机有8亿台,安防监控类7000万台,相机等消费类产品将有3.75亿台,汽车图像类传感器也将有3亿台,工业类也会有1.5亿台的规模,这无疑将对AI处理器构成莫大的压力。

“与视频编解码不同,现在的神经网络虽然看起来处理的图片很小,但是引入了卷积之后,整个通道数量就会很多,它的权重的数据量会非常的大,数据带宽就成为瓶颈。所以,现在包括业内不光是CEVA一家,大家都是在专注于怎么样去压缩数据上面。因此,我们增加了离线的权重压缩和硬件上的权重解压缩,来进一步优化数据带宽的瓶颈问题,但在这一版上,我们先是做的是数据的稀疏的权重的处理,就是权重的解压缩,那么未来我们也会直接做数据的压缩。”Moshe Sheier表示。

从架构层面上来看,Ner-Pro S究竟是如何去提升数据的使用效率的?Moshe Sheier告诉华强电子网记者:“目前为止,我们其实主要还是在带宽上做了一些增减。因为我们本身在设计NN引擎的时候,数据效率就已经很高了,即我们的乘法的利用率,理论的利用率,基本上都是在80-90%的水平。只是实际利用率达不到那么高,这也是因为瓶颈在带宽上,需要等待数据导致的问题。所以,这也是为什么我们NeoPro-S在NeoPro的基础上,将带宽做了更多的优化,这样才有可能去达到理论设计上的乘法优化。”

自定义硬件加速为什么要结合CV?

纵观如今市面上大多数AI芯片,配置专用的硬件加速器似乎已颇为流行,尤以AI图像处理及视觉识别这类最甚。从早期华为用于智能手机端的麒麟系列芯片、苹果的A11、A12到Nvidia用于汽车领域的Xavier,再到如今市场上不断涌现的众多类型的ASIC,专用的AI加速器似乎已成为一种标准配置,以针对特定应用的图像及视觉数据处理做专业支持。

虽说如今的自定义加速器已经成为各大AI芯片公司争相布局的领域,但在现今大多数AI加速的过程中,仍然需要传统CV技术的辅助。这是因为,有些神经网络现在还是在持续演进的过程当中,而CPU不仅需要做数据处理,还需要做一些其他的控制工作。因此,真正能够拿来来运行这些不支持的网络,或者是加一些新的Feature运算单元是远远不够的。因此,CEVA认为,CV和AI加速器结合的方案,将会是未来一大的趋势。

CEVA最新的NeuPro-S简图

为了辅助客户的自定义硬件加速器,CEVA则采用的Vision DSP来做相应的CV辅助。这样的话有两大好处,Moshe Sheier认为:“第一,如今的AI应用当中,我们有Pre AI和Boost AI,无论是要提前对图像做处理,做图像质量增强,还是做Resize,都是需要先做图像处理,这部就是我们的CV算法或者Resize,其实与AI的卷积并没有什么关系。还有就是Boost AI,当处理的图像数据出来之后,可能需要找一些框架,或者是按照概率排序,这其实也都是传统的CV的算法。”

况且,现在的很多神经网络都是级连的网络,先运行第一个,然后根据第一个的结果做CV的处理,再运行第二个。“所以,Vision DSP在这中间是非常关键的,我们之所以要更进一步,是因为我们本身有CDNN软件框架的积累。做硬件简单,但是做上层软件其实是很复杂的,所以我们是搭配我们的Vision DSP,同时我们也给客户提供了更加开放的CDNN的软件框架,这个软件框架我们会提供API的接口,可以把客户自己的硬件加速器的驱动集成到我们的接口里面来。然后以Vision DSP作为主控,去处理AI的一些应用。这是一个前后处理的概念,然后针对新的网络,如果硬件要求不支持,那么一定会是在Vision DSP上的效率会比在ARM上的效率要更高一些。”

专用加速器盛行是否代表AI算法已成熟?

过去的智能芯片端,主要是以DSP来实现所谓的“AI加速”。但如今,随着各类专用场景对智能化要求的提升,传统的DSP已经难以适应错综复杂的应用需求,因此专用的AI加速器成为了当下AI芯片领域的“新星”。当然,AI加速器的配置对提升固定应用场景下芯片的整体性能有很大助力,但性能提升的同时,灵活性也会进一步降低。那么,这是否意味着AI算法已经进入了相对成熟的阶段?

“我个人认为还没有到时候,跟视频编解码不一样,视频编解码行业我们可以包括ISP,可以明确说它一定是硬件的。因为它的算法演进过程中,也没有什么新的技术,所以其实提前布局是没有任何问题的。”Moshe Sheier解释。

但是现在,AI有一个很大的问题,就是算法公司内部其实走的是两条线路,一条是冲刺学术论文,整个算法非常的复杂;另外一条是本身算法公司做落地化的项目时,因为受困于硬件的计算算力不够,其实还是需要牺牲很多特征的。因此,CEVA非常希望算法公司能够跟芯片公司提更多的一样需求,让芯片公司设计的产品更适合自身的算法。

只有算法跑的效率高了,才能做更多的一些应用在里面。所以,Moshe Sheier认为AI加速器是一定是是一个趋势,当然这跟本身中国芯片公司都是硬件起家的背景是有关系的。另一方面,现在的视频DSP为什么还是很重要?这也是CEVA反复强调的,因为算法的不确定性实在太多了。而且,如今越来越多的算法公司,会更倾向于多个网络的组合算法,这样他们在AI上也会有越来越多的积累。 所以,一旦要运行多个网络,CV和AI的结合处理是非常必要的。

小结:

总之,在CEVA看来,AI自定义加速器以及AI与传统CV技术之间的结合将会是接下来AI处理器领域的两大趋势。站在一家全球领先的芯片IP提供商的角度,CEVA表示乐见更多的AI芯片厂商和算法公司与CEVA在AI处理器技术层面上展开合作,以共同推进AI芯片技术的发展。

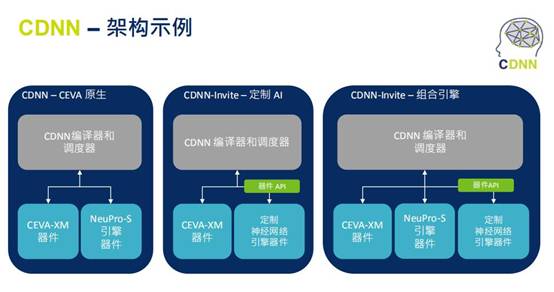

CEVA的CDNN架构示例

本次,CEVA推出的NeuPro-S,以及业界首创的深度神经网络编译器技术CDNN-Invite API,算是又一次提升了CEVA在AIoT芯片IP领域的地位,在处理、加速、软件和工具方面的整体能力又更进一步。不过,未来的AIoT市场,CEVA仍需提防ARM等一众竞争对手的狙击,只有在AIoT技术和生态上先发制人,并及时保证自身技术的快速迭代,方能在变幻莫测的AIoT时代立于不败之地。

分类资讯

热点排行

- 1两项指标均高于我们业务展望的中位数。

- 2用二氧化硅(SiO2)来消除边缘区域的电场

- 3该模块集成了几个基本组件

- 4新能源汽车产业的革新,离不开数字化、双碳两大时代底色

- 5应届毕业生大马,此前一直以为自己是足够幸运的那个

- 6从芯片行业的发展背景来看,芯片需离不开终端的发展

- 7全新高性价比工业级Cortex-A55核心板不限量发售

- 8中国电子展将以“创新强基 应用强链”为主题

- 9芯片厂商们披露业绩“创新高”

- 10元器件电子元器件的发展史其实就是一部浓缩的电子发展史